Apple anunciado la llegada de nuevas funciones de identificación con foto en iOS las cuales utilizarán algoritmos hash para hacer coincidir el contenido de las fotos de la galería de los usuarios con elementos conocidos de abuso infantil. Con ello el dispositivo cargará un conjunto de huellas digitales que representan el contenido ilegal y luego comparará cada foto en la galería del usuario con esa lista.

Como tal, esta función suena muy bien, pero en realidad tambien representa un verdadero problema, ya que como muchos nos podremos imaginar, esto podría causar una gran cantidad de conflictos, en especial con los «falsos positivos» y es que a juzgar por la cantidad de críticas negativas de Apple, esta iniciativa posiblemente no sea la mejor de la compañía en su lucha contra la pedofilia y la pornografía infantil.

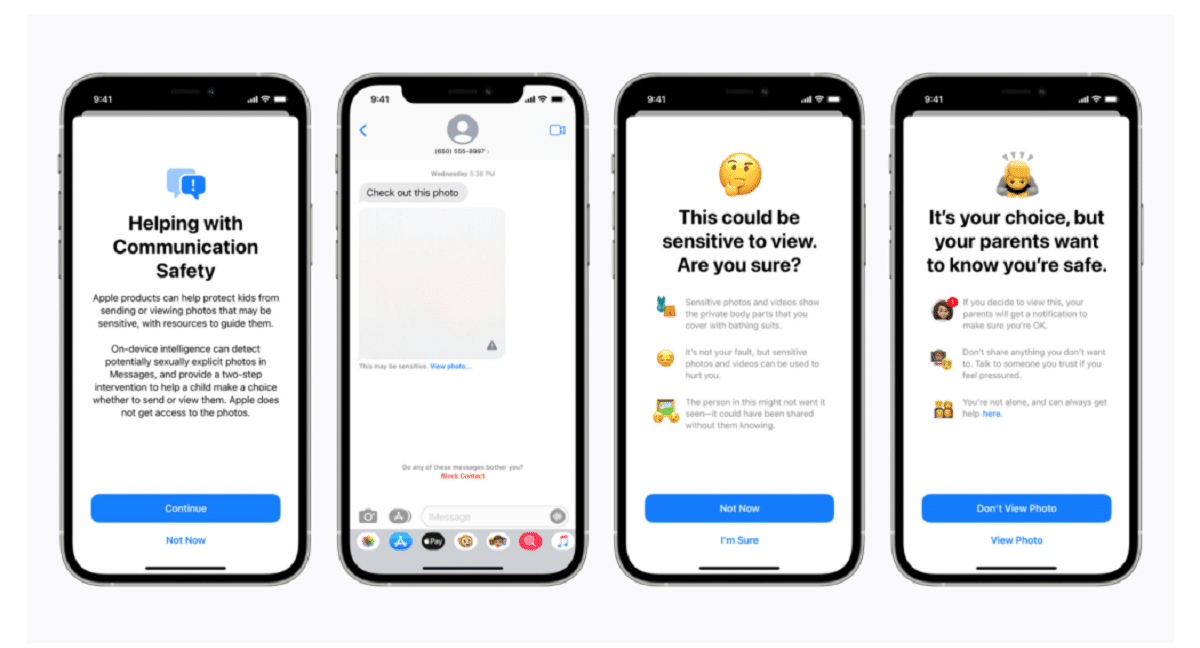

Apple confirmó en una publicación de blog, diciendo que la tecnología de escaneo es parte de una nueva serie de sistemas de protección infantil que «evolucionarán y se desarrollarán con el tiempo». Las funciones se implementarán como parte de iOS 15, cuyo lanzamiento está programado para el próximo mes.

«Esta nueva tecnología innovadora permite a Apple proporcionar información valiosa y procesable al Centro Nacional para Menores Desaparecidos y Explotados y a las fuerzas del orden sobre la proliferación de material conocido de abuso sexual infantil», dijo la compañía.

El sistema, llamado neuralMatch, alertará de forma proactiva a un equipo de examinadores humanos si cree que se detectan imágenes ilegales los cuales se pondrán en contacto con la policía si se puede verificar el material. El sistema neuralMatch, que se entrenó con 200.000 imágenes del Centro Nacional para Niños Desaparecidos y Explotados, se implementará por primera vez en los Estados Unidos. Las fotos serán hash y se compararán con una base de datos de imágenes conocidas de abuso sexual infantil.

Según las explicaciones de Apple cada foto subida a iCloud en Estados Unidos recibirá un «bono de seguridad» indicando si es sospechosa o no. Por lo tanto, una vez que un cierto número de fotos se marcan como sospechosas, Apple permitirá el descifrado de todas las fotos sospechosas y, si parecen ilegales, las reenviará a las autoridades correspondientes.

«Apple solo ve las fotos de los usuarios si tienen una colección de CSAM conocidos en su cuenta de iCloud Photos», dijo la compañía en un intento de asegurarles a los usuarios que sus datos son confidenciales.

Cabe señalar que neuralMatch representa el último intento de Apple de lograr un compromiso entre su propia promesa de proteger la privacidad del cliente y las demandas de los gobiernos, las fuerzas del orden y los activistas de seguridad infantil de una mayor asistencia en las investigaciones criminales, incluido el terrorismo y la pornografía infantil. La tensión entre empresas de tecnología como Apple y Facebook, que han defendido su creciente uso del cifrado en sus productos y servicios, y la aplicación de la ley solo se ha intensificado desde 2016.

Matthew Green, profesor de la Universidad Johns Hopkins y criptógrafo, compartió sus preocupaciones sobre el sistema en Twitter el miércoles por la noche. “Este tipo de herramienta puede ser una bendición para encontrar pornografía infantil en los teléfonos de las personas”, dijo Green.

«Pero imagínense lo que podría hacer en manos de un gobierno autoritario», preguntó. Esto preocupa a los investigadores de seguridad que advierten que podría abrir la puerta a la monitorización de los dispositivos personales de millones de personas. Los investigadores de seguridad, aunque respaldan los esfuerzos de Apple para abordar el abuso infantil, temen que la compañía pueda permitir que los gobiernos de todo el mundo busquen acceso a los datos personales de sus ciudadanos, potencialmente mucho más allá de su intención original.

El precedente establecido por Apple también podría aumentar la presión sobre otras empresas tecnológicas para que utilicen técnicas similares. “Los gobiernos se lo exigirán a todo el mundo”, menciono Green.

Los sistemas de almacenamiento de fotografías en la nube y los sitios de redes sociales ya buscan imágenes de abuso infantil. Apple usa, por ejemplo, técnicas de hash cuando las fotos se cargan en Fotos de iCloud. Todas las fotos cargadas en iCloud Photos para copia de seguridad y sincronización no se almacenan en cifrado de extremo a extremo. Las fotos se almacenan en forma cifrada en las granjas de servidores de Apple, pero las claves de descifrado también son propiedad de Apple. Esto significa que la policía puede citar a Apple y ver todas las fotos cargadas por un usuario.

Fuente: https://www.apple.com

from Desde Linux https://ift.tt/3xsVFsR

via IFTTT

No hay comentarios.:

Publicar un comentario