El crimen real es un tema que está en auge actualmente. No obstante, algunas cuentas en TikTok han llevado esta fascinación por el crimen real a un nivel preocupante, creando vídeos de inteligencia artificial (IA) que presentan a víctimas de asesinato, a menudo menores, hablando de cómo perdieron la vida.

En un reportaje de la revista Rolling Stone , el profesor Paul Bleakley, asistente de justicia penal en la Universidad de New Haven, expresó su preocupación sobre estos casos:

Son bastante desconcertantes y aterradores. Parecen diseñados para desencadenar reacciones emocionales intensas, porque es la forma más segura de conseguir clics y ‘me gusta’. Es incómodo de ver, pero creo que ese es el punto.

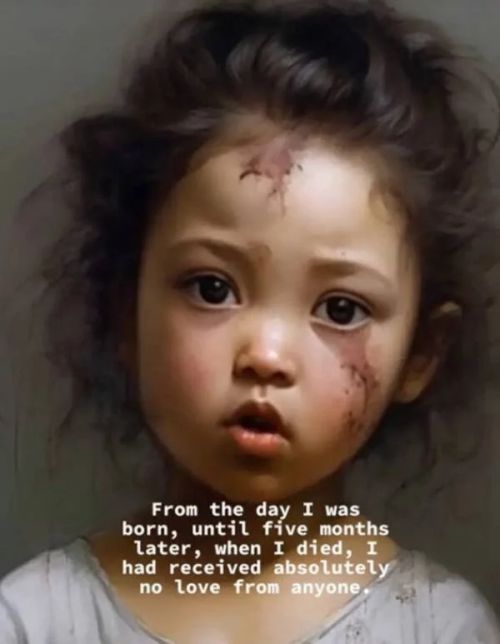

Cuentas como @truestorynow y Nostalgia Narratives, que cuentan con decenas de miles de seguidores, publican videos en los que víctimas de asesinato explican con frialdad lo que sucedió cuando perdieron la vida. Algunos presentan a víctimas adultas famosas, como George Floyd, pero muchos representan a menores.

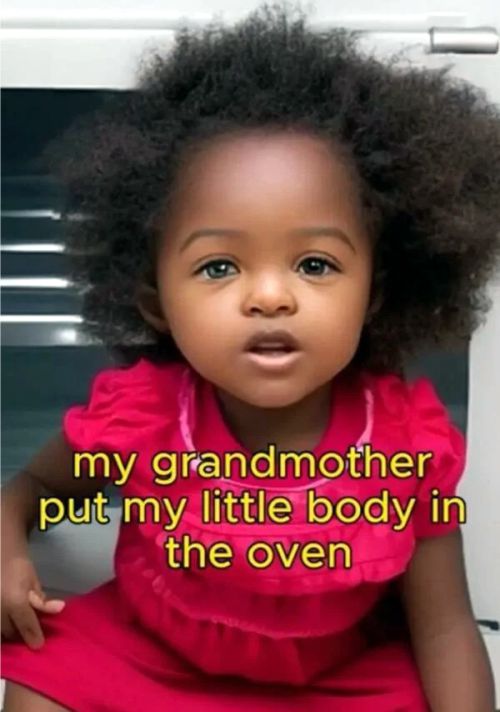

«La abuela me metió en un horno a 230 grados cuando sólo tenía 21 meses», se oye en un breve vídeo de uno de los deepfakes de IA publicados en @truestorynow. Identificada como Rody Marie Floyd en el clip, la niña generada en el vídeo relata la verdadera historia de Royalty Marie Floyd , una niña de 20 meses que fue apuñalada y luego quemada en un horno por su abuela en 2018.

Ese mismo año, la madre de la niña publicó en Facebook un mensaje en el que expresaba su dolor:

Royalty Marie Floyd fue lo mejor que me ha pasado. Era mi primera y única hija. Mi primer amor. Lo más duro que he tenido que enfrentar en mi vida. Siento como si me hubieran arrancado el corazón del pecho.

Clips como el de «Rody» han acumulado millones de reproducciones en TikTok.

Cuentas como Nostalgia Narratives alegan que no utilizan fotografías reales de las víctimas para generar los deepfakes, por «respeto a la familia». Sin embargo, el uso de estas imágenes también está prohibido en TikTok. Las directrices de la comunidad de la plataforma prohíben las representaciones falsas de personas privadas o jóvenes.

Independientemente de si las fotos son auténticas o no, la historia sí lo es. Y expertos como Bleakley creen que este tipo de contenido, utilizado sin el consentimiento de la familia, puede perjudicar en última instancia a los seres queridos de la víctima.

Algo así tiene un potencial real para revictimizar a las personas que ya han sido víctimas antes. Imagínate ser el padre o un pariente de uno de estos niños en estos videos de IA. Enciendes Internet y, con esta voz extraña y chillona, aquí tienes una imagen de IA basada en tu hijo fallecido, que entra en detalles gráficos sobre lo que les sucedió.

Según la revista Rolling Stone, de momento, vídeos como estos son completamente legales. No existe una ley que prohíba explícitamente las imágenes y vídeos falsos sin consentimiento. Y aunque las familias de las víctimas de asesinato pueden encontrar molestos los deepfakes, no hay un recurso legal claro que puedan tomar.

Además, los clips de IA de víctimas de asesinato que aparecen en TikTok podrían empeorar. Tampoco hay nada que impida a los creadores de contenido recrear crímenes utilizando inteligencia artificial, e incluyendo hasta el más mínimo y horripilante detalle.

«Esta es siempre la cuestión con cualquier nuevo avance tecnológico», apuntó Bleakley. «¿Hasta dónde llegará?»

TikTok ha tomado medidas para frenar la avalancha de deepfakes de víctimas de asesinato.

La cuenta @truestorynow, que contaba con casi 50.000 seguidores, ha sido eliminada. Sin embargo, en toda la plataforma, otros deepfakes siguen siendo fácilmente localizables.

El cargo El lado oscuro de TikTok: Deepfakes de víctimas de asesinato apareció primero en Tecnovedosos.

source https://tecnovedosos.com/deepfakes-victimas-asesinato-tiktok/

No hay comentarios.:

Publicar un comentario