Abril 2023: Lo bueno, malo e interesante del Software Libre

Hoy, penúltimo día de «abril 2023», como de costumbre, al final de cada mes, les traemos este pequeño compendio, con algunas de las más destacadas publicaciones de dicho periodo.

Para que disfruten y compartan más fácilmente algunas de las mejores y más relevantes informaciones, noticias, tutoriales, manuales, guías y lanzamientos, de nuestra web. Y de otras fuentes confiables, como la web DistroWatch, la Fundación para el Software Libre (FSF), la Iniciativa de Código Abierto (OSI) y la Fundación Linux (LF).

De manera tal, de que puedan más fácilmente mantenerse al día en el ámbito del Software Libre, Código Abierto y GNU/Linux, y otros ámbitos relacionados con la actualidad tecnológica.

Resumen de abril 2023

Dentro de DesdeLinux en abril 2023

Buenas

Malas

Interesantes

Top 10: Publicaciones recomendadas

- Abril 2023: Acontecer informativo del mes sobre GNU/Linux: Resumen noticioso sobre GNU/Linux, el Software Libre y el Código Abierto del mes en curso que empieza. (Ver)

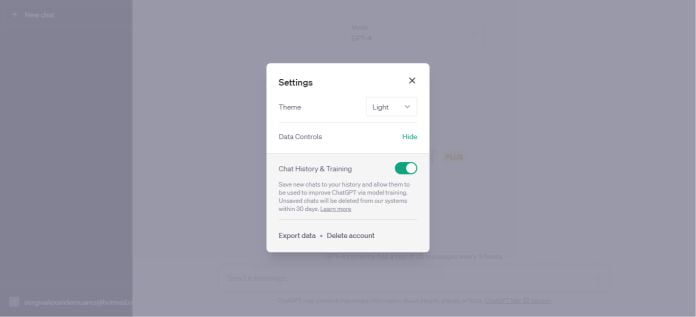

- Sage: Una plataforma web de IA para usar chatbots en Linux: Sage es un servicio web de IA que permite a cualquiera crear, implementar y gestionar chatbots de manera rápida y sencilla. (Ver)

- Debian 12 RC1: ¡Ya disponible para todos, Debian Bookworm!: El 03 de abril se nos ha anunciado oficialmente de la disponibilidad de una primera ISO de pruebas para Debian 12 RC1. (Ver)

- GPTGO.AI: Un útil buscador en línea con IA vía ChatGPT: Un sitio web cuyo objetivo es la búsqueda en línea al más puro estilo de Google.com, pero combinando la misma, con ChatGPT gratis. (Ver)

- Chrome 112 llega con mejoras de seguridad, dice adiós a Chrome Apps y más: Además de las innovaciones y la corrección de errores, se han corregido 16 vulnerabilidades en esta versión. (Ver)

- Script LPI SOA: Haz tu app Linux de mantenimiento y actualización: Script gráfico de Bash Shell que funciona como una app de Software Libre que emula un tradicional Asistente Técnico Virtual. (Ver)

- Mejores apps libres, abiertas y gratuitas para Linux en el 2023: Una útil propuesta con un Top 10 de mejores apps por categorías que serían geniales tener presentes en una Distro GNU/Linux. (Ver)

- Firefox 112.0 introduce mejoras de rendimiento: Esta nueva versión presenta mejoras de rendimiento, y muchas otras, como la posibilidad de restaurar la sesión anterior usando un atajo. (Ver)

- Libreboot 20230413 ya fue liberado y estas son sus novedades: Una versión de corrección de errores relativa a Libreboot 20230319. (Ver)

- LXQt 1.3 ya fue liberado y aún no se realiza el salto a Qt 6: Esta nueva versión aún se basa en la última versión LTS del marco Qt 5.15. (Ver)

Fuera de DesdeLinux en abril 2023

Lanzamientos de Distros GNU/Linux según DistroWatch

- ExTiX 23.4: 03/04/2023.

- OpenBSD 7.3: 10/04/2023.

- 4MLinux 42.0: 10/04/2023.

- FreeBSD 13.2: 11/04/2023.

- TrueNAS 22.12.2 «SCALE»: 12/04/2023

- Tiny Core Linux 14.0: 12/04/2023.

- EuroLinux 8.8 Beta: 13/04/2023.

- Deepin 20.9: 18/04/2023.

- Fedora 38: 18/04/2023.

- Ubuntu 23.04 original y sus ediciones Mate, Kubuntu, Budgie: 20/04/2023.

- Ubuntu 23.04 Cinnamon, Studio, Xubuntu, Edubuntu, Unity, Lubuntu y Kylin: 21/04/2023.

- Voyager Live 23.04: 21/04/2023.

- Manjaro Linux 22.1.0: 22/04/2023.

- BlendOS 2023.04.22: 22/04/2023.

- Peropesis 2.1: 26/04/2023.

Para profundizar más información sobre cada uno de estos lanzamientos y otros más, haga clic en el siguiente enlace.

Últimas Noticias de la Fundación para el Software Libre (FSF / FSFE)

- La FSFE está ayudando a construir una «Internet de los humanos»: ¿Cómo están dando forma a nuestro futuro las innovaciones tecnológicas emergentes? ¿Cómo será la Internet del futuro? La Free Software Foundation Europa (FSFE) cree que el software libre es la clave para una Internet accesible, abierta, transparente y diversa que respete los derechos humanos en los espacios digitales. Por ello, desde 2018, la FSFE es socia de diversos proyectos que forman parte de la iniciativa Next Generation Internet (NGI) de la Comisión Europea para hacer realidad este sueño. (Ver)

Para profundizar más, sobre esta información y otras noticias del mismo periodo, haga clic en los siguientes enlaces: FSF y FSFE.

Últimas Noticias de la Iniciativa de Código Abierto (OSI)

-

Los contenedores pueden ser más seguros con Código Abierto: La adopción de contenedores se está disparando, gracias al código abierto. La mayoría de los proyectos y herramientas para la gestión de contenedores en el ecosistema nativo de la nube son de código abierto. Sin embargo, según el Informe de contenedores de 2022, la cantidad de vulnerabilidades en los contenedores públicos está aumentando: el 60 % de los principales contenedores públicos tienen más vulnerabilidades que hace un año. Pero, a medida que el uso del código abierto se extienda, esto puede mejorar. (Ver)

Para profundizar más, sobre esta información y otras noticias del mismo periodo, haga clic en el siguiente enlace.

Últimas Noticias de la Organización Fundación Linux (FL)

-

Esta nueva fundación busca promover la adopción y el desarrollo del lenguaje de programación TLA+ y su comunidad de practicantes de TLA+. Sus miembros inaugurales incluyen a Amazon Web Services (AWS), Oracle y Microsoft. TLA+ es un lenguaje de alto nivel para modelar programas y sistemas, especialmente simultáneos y distribuidos. Y es muy útil para verificar sistemas de software complejos, reduciendo errores y mejorando la confiabilidad. (Ver)

Para profundizar más, sobre esta información y otras noticias del mismo periodo, haga clic en los siguientes enlaces: Fundación Linux, en inglés; y la Fundación Linux Europa, en español.

Resumen

En resumen, esperamos que este “pequeño y útil compendio de noticias” con lo más destacado dentro y fuera del Blog «DesdeLinux» para este segundo mes del año, «abril 2023», sea un gran aporte al mejoramiento, crecimiento y difusión de las «tecnologías libres y abiertas».

Si te ha gustado esta publicación, no dejes de comentarla y de compartirla con otros. Y recuerda, visitar nuestra «página de inicio» para explorar más noticias, además de unirte a nuestro canal oficial de Telegram de DesdeLinux, o este grupo para más información sobre el tema de hoy.

from Desde Linux https://ift.tt/CmaUJpv

via IFTTT